تتسم المخاوف التي تحيط باستخدام الذكاء الاصطناعي بأنها كثيرةٌ ومتشعبة، حتى إن شخصيات بارزة في مجال التكنولوجيا قد حذرت من التهديدات التي قد يحملها، مثل الهجمات السيبرانية المعتمدة على الذكاء الاصطناعي وتفشي البطالة نتيجة استيلائه على الوظائف والروبوتات القاتلة وغيرها. وكان آخرهم أرفيند كريشنا، الرئيس التنفيذي لشركة آي بي إم (IBM)، الذي قال مؤخراً في مقابلة مع صحيفة وال ستريت جورنال: "علينا أن نتعامل مع المسائل الأخلاقية المرتبطة بالذكاء الاصطناعي، وأن نضمن عدم تكرار أخطاء الماضي. ينبغي على البشرية أن تفهم العلوم التي يقوم عليها الذكاء الاصطناعي وإلا سينتهي بنا المطاف بخلق وحش".

لكن، مثل أي تكنولوجيا، فإن تأثير الذكاء الاصطناعي يعتمد على كيفية استغلالنا له. ولذا سنتطرق إلى أهم هذه المخاوف ونسلط الضوء على العمل القائم لتجاوز بعضها.

1- مشكلة تحيز الذكاء الاصطناعي

إن اعتماد خوارزميات الذكاء الاصطناعي على البيانات الفعلية في عملية تدريبها قد أورثها ما تتضمنه هذه البيانات من عيوب مجتمعية مثل التحيز والعنصرية والتمييز على أساس الجنس أو العرق أو الإعاقة. كما يمكن للتحيز أن يتسرب إلى خوارزميات التعلم الآلي خلال مرحلة جمع البيانات أو إعدادها؛ فقد تكون البيانات لا تمثل الواقع أو ربما تعكس أوجه التحيز الموجودة.

لنوضح هذه المشكلة بمثالٍ واقعي؛ استعرضنا في مقالة سابقة بعنوان "دليل شامل ومبسط حول مفهوم الذكاء الاصطناعي" كيف تستعين خوارزميات التعلم الآلي بالإحصاءات للعثور على أنماطٍ متكررة في البيانات، لذا إذا تم تغذية الخوارزميات بالسجل الجنائي مثلاً، فسوف تُخرج لنا أنماطاً متصلة بالجريمة. وستجد علاقة بين تدني الدخل وارتكاب الجرائم. وهي في الحقيقة علاقة ترابط وليست علاقة سببية، لكن خوارزميات التعلم الآلي وأنظمة الذكاء الاصطناعي الحالية لا تستطيع أن تدرك معنى السببية ولا التمييز بينها وبين الارتباط. وبالتالي، أصبح الأفراد الذين تم استهدافهم تاريخياً بشكل غير منصف من قِبل الشرطة، عرضةً لنفس الظلم لكن هذه المرة من قِبل الخوارزميات، ونتيجةً لذلك، يتم إرسال الناس إلى السجن عن طريق الخطأ.

وقد سلطت العديد من الدراسات الضوء على هذه المشكلة في عدة مجالات أخرى. على سبيل المثال، كشف باحثون من جامعة كاليفورنيا أن إحدى الخوارزميات الطبية تمنح تفضيلاً لذوي البشرة الفاتحة في برامج الرعاية الصحية. وقد سلطنا الضوء على العديد من جوانب تحيز الذكاء الاصطناعي في مجال الطب في مقالتنا: "الذكاء الاصطناعي في الطب: خطر التحيز يهدد تطبيقاته الواسعة". كما تم فتح تحقيق بشأن الخوارزمية المُعتمَدة لتقرير الحدود الائتمانية لمستخدمي بطاقة آبل الائتمانية (آبل كارد)؛ حيث يبدو أن هذه الخوارزمية تمنح الرجال حدوداً ائتمانية أعلى من النساء. كما تم تأكيد عنصرية معظم أنظمة التعرف على الوجوه وفقاً لدراسة حكومية أميركية.

الحلول المقترحة

يرى الخبراء أن حل مشكلة التحيز في الذكاء الاصطناعي يتطلب تضافر جهود صانعي السياسات والمشرعين مع مطوري الخوارزميات لاكتشاف الطريقة الأفضل لتصميم خوارزميات أكثر إنصافاً وتنظيم استخدامها.

ويعمل الباحثون على مجموعة من الأساليب للتخفيف من هذه المشكلة مثل: الخوارزميات التي تساعد في الكشف عن التحيزات في أنظمة التعلم الآلي، وتحميل الشركات مسؤولية الحصول على نتائج أكثر إنصافاً، وإطلاق نقاشات حول التعاريف المختلفة للإنصاف الخوارزمي. ومؤخراً، توصل باحثون من جامعة إم آي تي إلى تطوير تقنية جديدة تعمل على تقليل تحيز نماذج الذكاء الاصطناعي، وإدخال العدل والإنصاف في التمثيل الداخلي للنموذج نفسه، حتى لو كانت البيانات التي تدرّب عليها النموذج غير عادلة.

اقرأ المزيد من مقالاتنا حول مشكلة التحيز في الذكاء الاصطناعي:

- هل يمكنك أن تجعل الذكاء الاصطناعي أكثر عدلاً من القاضي؟ جرب لعبتنا للمحاكمة بالخوارزميات

- كيف نجعل الإقراض أكثر إنصافاً للنساء؟ الحلّ سهل ولكنه غير قانوني

- التحيز في لينكدإن: الذكاء الاصطناعي هو المشكلة والحل في الوقت نفسه

2- تلوث البيئة والاستهلاك الكبير للموارد

غالباً ما تُقارن صناعة الذكاء الاصطناعي بصناعة النفط، فما أن يتم استخراج البيانات وتدقيقها، تصبح -شأنها شأن النفط- سلعة تُدرّ أرباحاً طائلة. ويبدو أن التشبيه أصبح الآن أعمق من ذي قبل؛ حيث إن عملية التعلم العميق تؤثر على البيئة بشكل واضح، شأنها شأن الوقود الأحفوري.

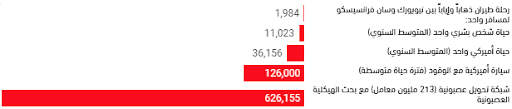

فقد أجرى باحثون في جامعة ماساتشوستس أمهيرست تقييماً لدورة حياة تدريب عدة نماذج كبيرة للذكاء الاصطناعي، ووجدوا أن هذه العملية يمكن أن تصدر أكثر من 283,000 كيلوجرام من ثنائي أكسيد الكربون المكافئ، أي ما يعادل تقريباً خمسة أضعاف الانبعاثات التي تطلقها سيارة أميركية متوسطة مدى حياتها، بما في ذلك تصنيع السيارة نفسها.

كما وجد الباحثون أن التكاليف الحاسوبية والبيئية لعملية تدريب نماذج معالجة اللغات الطبيعية تتزايد بشكل طردي مع حجم النموذج. ففي عام 2018، نشرت أوبن أيه آي دراسة تبين أن الموارد الحاسوبية المطلوبة لتدريب النماذج الكبيرة تتضاعف كل ثلاثة أو أربعة أشهر. ويثير هذا التسارع المخاوف من تأثيراته على التنوع والتقدم ضمن الحقل؛ حيث إن ضخامة الموارد المطلوبة للحصول على نتائج جيدة تعطي أفضلية للمختبرات الخاصة على المختبرات الأكاديمية، وهو ما يمكن أن يقيد تطور الحقل بالمشاريع قصيرة الأمد التي غالباً ما تكون متوافقة مع أهداف الشركات، بدلاً من المشاريع بعيدة الأمد التي يمكن أن تفيد العامة.

الحلول المقترحة

في مسعى للتخفيف من حدة هذا التوجه، قام باحثون من معهد آلين للذكاء الاصطناعي بتقديم اقتراحات عملية للحد من تأثير الذكاء الاصطناعي على المناخ، والتي تتضمن إلزام باحثي الذكاء الاصطناعي بنشر التكاليف الحاسوبية والمالية لتدريب نماذجهم، جنباً إلى جنب مع نتائج الأداء. ويأمل الباحثون في أن تحفز زيادة الشفافية حول ما تتطلبه زيادة الأداء على زيادة الاستثمار في تطوير خوارزميات أكثر فعالية للتعلم الآلي.

ويكمن الجانب الآخر من الحل في تطوير عتاد صلب أرخص وأقل استهلاكاً للموارد، وهو ما تعمل عليه العديد من الشركات من خلال تصميم شرائح إلكترونية أكثر فعالية من حيث التكلفة واستهلاك الطاقة.

وفي مايو/أيار من عام 2021، اقترحت دراسة أجراها باحثون من جوجل عدة استراتيجيات يمكن أن تلعب دوراً رئيسياً في درجة تأثير الذكاء الاصطناعي على البيئة. وأشارت الدراسة إلى أنه من الممكن تخفيف البصمة الكربونية لعملية تدريب نموذج كبير حتى 1,000 مرة من خلال اتباع استراتيجيات معينة في تصميم النموذج واختيار مركز البيانات والمعالجات المستخدمة في التدريب.

اقرأ أيضاً:

- كيف يمكن للقراصنة دفع الذكاء الاصطناعي لاستهلاك المزيد من الطاقة؟

- عتاد صلب كمومي لكبح نهم الذكاء الاصطناعي للطاقة

- كيف يمكن تخفيف تأثير الذكاء الاصطناعي على البيئة؟

3- الخصوصية

مع الانتشار الواسع لتطبيقات الذكاء الاصطناعي مثل التعرف على الوجوه والمساعدات الصوتية وغيرها، أصبحت الشركات أكثر شراهةً للبيانات التي تشكل المادة الخام لتدريب خوارزمياتها.

وعلى سبيل المثال، حصلت جوجل في عام 2019 على صفقة تمكنها من الوصول إلى البيانات الصحية الشخصية لملايين الأميركيين، ما أثار الريبة لدى الكثيرين من سهولة وصول الشركات إلى بياناتهم الخاصة، خصوصاً بعد فضيحتي تسريب آلاف المقاطع الصوتية لجوجل أسيستانت، ومشاركة آبل لمعلومات حساسة حول مستخدمي سيري مع عاملين من البشر.

وهذا بالضبط ما دفع مجموعات الحريات المدنية إلى التحذير من مستقبل كئيب تتحول فيه التكنولوجيا إلى سيف مسلط على رقاب الجميع، حيث أنها تتمتع بقدرة كبيرة على انتهاك الخصوصية. على سبيل المثال، دعت 40 مجموعة من مناصري الخصوصية الولايات المتحدة إلى حظر تكنولوجيا التعرف على الوجوه.

ووفقاً لدراسةٍ أجراها مركز بيو للأبحاث في أميركا، فإنَّ أكثر من 60% من الأميركيين يعتقدون- مستائين- أنه من المستحيل ممارسة الحياة اليومية بعيداً عن تتبع الشركات أو الحكومة لمعلوماتهم الخاصة. كما وجدت دراسةٌ استقصائية في المملكة المتحدة أن 46% من الجمهور يعتقدون أنه يجب أن يكونوا قادرين على اختيار عدم الخضوع لتكنولوجيا التعرف على الوجوه.

الحلول المقترحة

تعتمد استدامة تطبيقات الذكاء الاصطناعي على إيجاد طريقة للاستفادة من البيانات مع الحفاظ على خصوصية الناس.

ومن أجل تحقيق ذلك، شرعت بعض الشركات باستخدام تقنيات جديدة مثل التعلم الموحد والخصوصية التفاضلية كوسيلة لتحسين أداء خوارزميات الذكاء الاصطناعي لديها دون المساس بخصوصية المستخدمين.

من ناحيةٍ أخرى، لا يمكن للتكنولوجيا وحدها حل هذه المشكلة؛ إذ ينبغي تطوير بيئة تنظيمية تضمن الحفاظ على أمان بيانات المستخدمين وتواكب الوتيرة السريعة لتبني تكنولوجيات الذكاء الاصطناعي وتوفر الشفافية حول طريقة استخدامها.

ويعتبر القانون الأوروبي العام لحماية البيانات أحد الأمثلة الرائدة لمواجهة مشكلة الخصوصية؛ حيث يتضمن مجموعة واسعة من القواعد التي تعطي الأفراد الحق في حماية خصوصية بياناتهم.

اقرأ المزيد من مقالاتنا حول تأثير الذكاء الاصطناعي على الخصوصية:

- كيف تمنع الذكاء الاصطناعي من التعرف على وجهك في صور السيلفي؟

- كيف تحمي بياناتك الشخصية من بوتات الذكاء الاصطناعي؟

- الوكالات الحكومية الأميركية تخطط لزيادة استخدام تكنولوجيا التعرف على الوجوه

4- القدرة على التزييف العميق

إن التقدم الكبير في مجال معالجة اللغات الطبيعية والتعلم العميق قد حمل معه بعض العواقب السلبية؛ إذ يمكن استخدامها في توليد أخبار وصور وفيديوهات مزيفة تبدو مقنعة للغاية.

حيث تمكن باحثون من تطوير خوارزمية لغوية ذات أغراض عامة يتم تزويدها بمليارات الكلمات لتؤلف مقالات مقنعة وبشكلٍ يظهر قدرة الذكاء الاصطناعي على خداع الناس على نطاق واسع. كما ظهرت دلائل على استخدام الذكاء الاصطناعي في عمليات الدعاية وتزييف المعلومات.

ومن جانبٍ آخر، تهدد خوارزميات التزييف العميق بزرع الشك في كل ما نشاهده وأصبحت رمزاً لنهاية الحقيقة، وبالنسبة للبعض فهي تشكل أداةً للتلاعب بالانتخابات. ومنذ ظهور تقنية التزييف العميق، تم استخدامها بشكل أساسي في إنشاء تمثيلات إباحية للنساء اللائي غالباً ما يجدن هذا أمراً مدمراً من الناحية النفسية. وكان آخرها هذا التطبيق الذي يستبدل وجوه النساء ويولد فيديوهات عميقة التزييف دون الحاجة لامتلاك أي خبرة فنية.

الحلول المقترحة

تتمثل إحدى خطوات تجنب الآثار السلبية للتزييف العميق في العمل على تطوير تكنولوجيات لمكافحته والحد من تأثيره وبناء أدوات اصطناع أكثر التزاماً بالمعايير الأخلاقية. على سبيل المثال، تعمل فيسبوك على صنع الكثير من الفيديوهات عميقة التزييف لمساعدة الباحثين على بناء الأدوات اللازمة للكشف عنها وتحسين هذه الأدوات.

أضف إلى ذلك بالطبع ضرورة توعية الناس بضرورة التحقق من الفيديوهات من خلال اللجوء إلى المصادر الرسمية والموثوقة والتي يتوجب عليها التحرك بسرعة لتوفير التوضيحات ودحض المقاطع المزيفة.

اقرأ المزيد من مقالاتنا حول التزييف العميق:

- كيف يستخدم التزييف العميق لاستحضار الأموات؟

- مخاطر التزييف العميق: تطبيق يستبدل وجوه النساء بنقرة زر

- أشخاص يؤجرون وجوههم لبناء نسخ تسويقية تعتمد على التزييف العميق

5- الملكية الفكرية

في معظم الأحيان، يكون الذكاء الاصطناعي مجرد أداة لمساعدتنا على الابتكار، ولكن ماذا سيحدث لو كان الذكاء الاصطناعي مسؤولاً بالكامل عن عملية الاختراع نفسها؟

إن الثورة التكنولوجية التي أطلقها الذكاء الاصطناعي تفرض علينا إعادة التفكير في العلاقة بين التكنولوجيا والعملية الإبداعية؛ ففي السابق، لم يسبب ابتكار الأعمال بمساعدة الحاسوب أية شكوك بخصوص ملكية هذه الأعمال، لأن الحاسوب كان مجرد أداة كالفرشاة بيد الرسام. أما اليوم فإن إنشاء أعمال فنية أو ابتكار اختراعات باستخدام الذكاء الاصطناعي قد يكون له تداعيات كبيرة على قوانين الملكية الفكرية؛ فهو لم يعد مجرد أداة وإنما يتولى اتخاذ العديد من القرارات خلال العملية الإبداعية دون أي تدخل بشري.

ومن الناحية القانونية، فإن معظم التشريعات الحالية تنص على أن حقوق الملكية الفكرية لا تحمي إلا الأعمال والابتكارات النابعة من بنات أفكار عقل بشري. لكن، وكما رأينا في الجزء السابق من هذه السلسلة، فإن الذكاء الاصطناعي قد بدأ بالفعل في تصميم لوحات فنية وتأليف الموسيقى، وهي أعمالٌ محكوم عليها بأن تكون خارج نطاق حقوق الملكية الفكرية وفقاً للتشريعات الحالية كونها ليست صادرة عن إنسان.

أخلاقيات الذكاء الاصطناعي

في ظل التطورات السريعة التي يمرّ بها الذكاء الاصطناعي وتطبيقاته وبعد أن رأينا حجم المسائل الإشكالية المتعلقة به، يطالب الكثير من الخبراء وصانعي السياسات بضرورة وضع حدود له من خلال قواعد تنظم عمله وتضمن أن لا يؤدي استخدامه في القطاعات المختلفة إلى عواقب سلبية على البشر أو الأنظمة الأخرى (لا بد أن هذا الأمر يذكرنا بقوانين إسحق عظيموف الثلاثة وفيلم آي روبوت).

ومؤخراً، أطلق تحالف "شراكة حول الذكاء الاصطناعي"- وهو تحالف يضم عمالقة شركات التكنولوجيا يهدف إلى البحث في أفضل ممارسات أنظمة الذكاء الاصطناعي وتعزيز فهم الجمهور لها- مشروعاً اسمه "وضع معايير النشر العلمي للوصول إلى ذكاء اصطناعي مسؤول" والذي يدعو الباحثين في هذا المجال إلى وضع قواعد حول توقيت وكيفية نشر أبحاثهم والنماذج التي يطورونها من أجل تفادي إساءة استخدامها لأغراض خبيثة.

اقرأ المزيد من مقالاتنا حول أخلاقيات الذكاء الاصطناعي:

- الكفاح من أجل إعادة الذكاء الاصطناعي إلى مساره الصحيح

- دليل شركات التكنولوجيا الكبرى للحديث عن أخلاقيات الذكاء الاصطناعي

- التعاون الدولي وأهميته في تطور الذكاء الاصطناعي

هل هناك حدود أخلاقية في تطوير الذكاء الاصطناعي؟

في الحقيقة، ليس هناك حدود أخلاقية واضحة في تطوير أنظمة ونماذج الذكاء الاصطناعي. وتكمن المشكلة الأساسية التي تواجهنا هفيي إيجاد طريقة لتحديد ما إذا كانت أنظمة الذكاء الاصطناعي أخلاقية أم لا، إذ لا توجد حالياً معايير تحدد ذلك. والسبب أننا لا نستطيع تعريف الذكاء الاصطناعي الأخلاقي.

نحن البشر قبل الآلات غير متفقين على المعايير الأخلاقية، حيث يختلف تعريف الأخلاق بين الشعوب والثقافات، وحين تسأل الأشخاص عما يعنيه لهم الذكاء الاصطناعي الأخلاقي، ستختلف الإجابة بناءً على اختلاف معاييرهم الأخلاقية وثقافاتهم وعاداتهم وتقاليدهم.

على سبيل المثال، إذا طورنا سيارات ذاتية القيادة تتمتع بأنظمة أخلاقية، ما الذي سنفعله في حال فشلها وتسببها بحوادث تؤدي لمقتل بعض البشر؟ ولوضع الأمور في سياق ملموس أكثر: هل يجب على السيارة ذاتية القيادة أن تتابع طريقها وتقتل ثلاثة مشاة كبار في العمر، أو تنحرف في مسارها حتى تصطدم بحاجز وتقتل ثلاثة ركاب يافعين؟ كان هذا السؤال محور دراسة طويلة الأمد شارك فيها ملايين الأشخاص من حول العالم. وتباينت الإجابات مع تباين الثقافات؛ فقد كان المشاركون من الثقافات جماعية الطابع (مثل الصين واليابان)، أقل ميلاً لتفضيل إنقاذ صغار السن بدلاً من كبار السن، ويقول الباحثون إن السبب قد يعود إلى التركيز الكبير على احترام كبار السن في هذه الثقافات. بينما مال المشاركون من البلدان ذات الثقافة فردية الطابع إلى إنقاذ صغار السن.

لهذا السبب، قد لا نكون قادرين على تطوير نظام ذكاء اصطناعي أخلاقي يمكن استخدامه في كل مكان، وقد يضطر المطورون لإنشاء أنظمة حسب المعايير الأخلاقية التي تميز كل دولة أو جماعة من البشر.

هل للذكاء الاصطناعي وتطبيقاته أثر في العلاقات الإنسانية؟

عندما أطلقت شركة أوبن إيه آي (OpenAI) نموذج تشات جي بي تي (ChatGPT) اللغوي، علق عليه أحد المستخدمين: "إنه أشبه بامتلاك صديق يمتلك كل المعرفة المتاحة حول أي شيء يخطر في بالك". ورغم أن الكثيرين قد اعتادوا على المساعدات الصوتية مثل أليكسا وسيري، لكنها لم توصف يوماً بأنها "صديق"، وإنما "مساعدات" لتأدية مهام محددة. وهنا تبرز الحاجة الملحة للإجابة على السؤال التالي: كيف سيؤثر تطوير ذكاء اصطناعي "قوي" أو "عام" على علاقاتنا البشرية؟ وهل سيؤدي إلى عزلة كل فرد مع "صديقه" البرمجي القائم على الذكاء الاصطناعي؟ هل سيؤدي تطوير الذكاء الاصطناعي العاطفي إلى الاستغناء عن الحاجة البشرية المتأصلة فينا إلى التواصل مع الآخرين والتعاطف معهم والتفاعل معهم؟

من ناحية أخرى، فإن توفر هذا النوع من الأنظمة ستريح كاهل البشر من أداء الكثير من المهام الرتيبة والمكررة والتي تستهلك حيزاً هاماً من وقتهم وحياتهم. وهذا يعني توفر المزيد من الوقت لقضائه مع العائلة والأصدقاء، والتركيز على الجوانب الإبداعية والعاطفية. بطبيعة الحال، سيبقى الموضوع رهناً بكيفية فهم هذه التكنولوجيا الثورية وتطويرها بطريقة متمحورة حول الإنسان وهادفة إلى تحسين حياته كفرد وفي المجتمع الذي يحيط به.

أخيراً:

تكمن عظمة الذكاء الاصطناعي في منح الآلات القدرة على الخروج عن الشيفرات البرمجية الساكنة لتصبح قادرة على الارتجال والإبداع ومنح الإلهام وتعزيز الإبداع والقدرة البشرية.

ويعتمد الاستغلال الإيجابي لكامل طاقته الكامنة على بناء ذكاء اصطناعي "جدير بالثقة" يحقق اختراقات كبيرة في شتى المجالات بشكلٍ يضمن العدالة والخصوصية وإشراك الجميع في مستقبل مشرق.