أدى الذكاء الاصطناعي إلى زيادة كبيرة في الإنتاجية، لكن في عالم الجريمة المظلم. يوفر الذكاء الاصطناعي التوليدي مجموعة أدوات جديدة وفعالة وتتيح للجهات الفاعلة الخبيثة العمل بكفاءة أكبر وعلى المستوى الدولي أكثر من ذي قبل بكثير، كما يقول أحد كبار الباحثين في مجال التهديدات في شركة تريند مايكرو (Trend Micro) الأمنية، فينشينتزو شانكالييني.

ويضيف شانكالييني قائلاً إن معظم المجرمين "لا يعيشون في مقر مظلم حيث يضعون مخططاتهم. بل إن معظمهم أشخاص عاديون يمارسون نشاطات اعتيادية تتطلب إنتاجية عالية أيضاً". شهد العام الماضي صعود وورم جي بي تي (WormGPT) وسقوطه، وهو نموذج ذكاء اصطناعي لغوي مبني بالاعتماد على نموذج مفتوح المصدر، ومُدرب على بيانات متعلقة بالبرمجيات الضارة، وقد صُمِّم لمساعدة قراصنة المعلومات، ولم يكن مزوداً بأي قواعد أو قيود أخلاقية. لكن مبتكريه أعلنوا الصيف الماضي أنهم سيوقفون عمل النموذج بعد أن بدأ يجتذب انتباه وسائل الإعلام. ومنذ ذلك الحين، توقف معظم المجرمين السيبرانيين عن تطوير نماذج ذكاء اصطناعي تخصهم. وقرروا بدلاً من ذلك اللجوء إلى حيل بمساعدة الأدوات المتاحة التي تعمل بصورة موثوقة.

ويوضح شانكالييني أن السبب في ذلك يعود إلى رغبة المجرمين في اتباع طرق سهلة وتحقيق الأرباح السريعة. وحتى تكون أي تكنولوجيا جديدة جديرة باستخدامها على الرغم من المخاطر المجهولة المرتبطة بها –مثل المخاطرة بانكشاف النشاط الإجرامي بدرجة أكبر- يجب أن تكون أفضل من التكنولوجيات المُستخدمة حالياً وأكثر قدرة منها على تحقيق مكاسب أكبر. إليك فيما يلي خمسة أساليب يستغل بها المجرمون الذكاء الاصطناعي حالياً.

التصيد الاحتيالي

يمثل التصيد الاحتيالي (Phishing) أبرز حالات الاستخدام للذكاء الاصطناعي التوليدي بين المجرمين حالياً، ويتضمن محاولة خداع الأفراد لدفعهم إلى كشف معلومات حساسة يمكن استخدامها لأغراض خبيثة، على حد تعبير الباحث في أمن الذكاء الاصطناعي في المعهد الاتحادي السويسري للتكنولوجيا في زيورخ، ميسلاف بالونوفيتش. وجد الباحثون أن ظهور تشات جي بي تي (ChatGPT) اقترن بزيادة حادة في عدد رسائل التصيد الاحتيالي الإلكترونية. وقد بادرت خدمات توليد رسائل البريد الإلكتروني العشوائية، مثل غوميل برو (GoMail Pro)، إلى دمج تشات جي بي تي في أنظمتها، ما يتيح للمستخدمين المجرمين ترجمة الرسائل التي يرسلونها إلى الضحايا أو تحسين تلك الرسائل، كما يقول شانكالييني.

تنص سياسات أوبن أيه آي (OpenAI) على منع المستخدمين من استغلال منتجاتها في نشاطات غير قانونية، لكن من الصعب مراقبة ذلك عملياً، حيث يمكن استخدام الكثير من الأوامر النصية التي تبدو بريئة لأغراض خبيثة أيضاً، كما يقول شانكالييني. تقول أوبن أيه آي إنها تستخدم مزيجاً من المراجعين البشر والأنظمة المؤتمتة من أجل كشف استخدام أنظمتها لأغراض مسيئة ومكافحة هذا الاستخدام، وإصدار التحذيرات، وفرض التعليق المؤقت أو الحظر الكامل عند انتهاك المستخدمين لسياسات الشركة. وقد قال لنا متحدث رسمي باسم أوبن أيه آي: "نحن نأخذ سلامة منتجاتنا على محمل الجد، ونعمل باستمرار على تحسين تدابير السلامة لدينا بناء على كيفية استخدام الناس لمنتجاتنا". وأضاف قائلاً: "نعمل باستمرار على جعل نماذجنا أكثر أماناً وأقوى في مواجهة إساءة الاستخدام وعمليات كسر الحماية، مع الحفاظ في الوقت نفسه على فائدة النماذج ومستوى أدائها للمهام".

في تقرير يعود إلى شهر فبراير/شباط، قالت أوبن أيه آي إنها أغلقت خمسة حسابات مرتبطة بجهات فاعلة خبيثة تتبع لجهات حكومية. من قبل، كان من السهل اكتشاف عمليات احتيال تعرف باسم "عمليات احتيال الأمير النيجيري"، حيث تتلقى الضحية وعداً من شخص مجهول بالحصول على مبلغ كبير من المال لقاء دفعة صغيرة مقدماً، فقد كانت اللغة الإنجليزية المستخدمة في تلك الرسائل ضعيفة ومليئة بالأخطاء النحوية، كما يقول شانكالييني. تتيح النماذج اللغوية للمحتالين توليد رسائل توحي بأن من كتبها يتحدث الإنجليزية بطلاقة. يقول شانكالييني: "كان الأشخاص الناطقون باللغة الإنجليزية آمنين نسبياً من المجرمين غير الناطقين بالإنجليزية، لأنه كان من السهل كشف رسائلهم".

لكن الوضع تغير الآن. فبعد أن تحسنت قدرة الذكاء الاصطناعي على الترجمة، أصبحت المجموعات الإجرامية المختلفة حول العالم قادرة على التواصل فيما بينها بصورة أفضل أيضاً. ويقول شانكالييني إن الخطر يكمن هنا في أنهم أصبحوا قادرين على تنسيق عمليات واسعة النطاق تتجاوز حدود بلدانهم وتستهدف الضحايا في بلدان أخرى.

عمليات الاحتيال الصوتية العميقة التزييف

أتاح الذكاء الاصطناعي التوليدي تحقيق قفزة كبيرة في تطوير المزيفات العميقة، حيث أصبحت الصور ومقاطع الفيديو ومقاطع الصوت الاصطناعية [كلها] أكثر واقعية من أي وقت مضى. وقد كانت مجتمعات عالم الجريمة المظلم تتابع هذه التطورات بدقة. ففي وقت سابق من هذا العام، أفادت التقارير أن موظفاً في هونغ كونغ تعرض لعملية احتيال أدت إلى الاستيلاء على 25 مليون دولار من أمواله بعد أن استخدم مجرمون سيبرانيون نسخة عميقة التزييف من الرئيس التنفيذي للشؤون المالية في الشركة لإقناع الموظف بتحويل المبلغ إلى حساب المحتال.

يقول شانكالييني: "لقد شهدنا في نهاية المطاف تسويقاً للمزيفات العميقة في أوساط الخارجين عن القانون". وقد اكتشف فريقه بعض الأشخاص على منصات مثل تيليجرام (Telegram) وهم يعرضون "محفظة" من المزيفات العميقة، ويقدمون خدماتهم لقاء مبالغ لا تتجاوز في بعض الأحيان 10 دولارات للصورة الواحدة أو 500 دولار لكل دقيقة من الفيديو. يقول شانكالييني إن إيلون ماسك يُعد واحداً من الشخصيات المفضلة لدى المجرمين لإنتاج مزيفات عميقة لها.

وبينما تظل مقاطع الفيديو العميقة التزييف معقدة في إنتاجها ويسهل على البشر كشفها، فإن هذا لا ينطبق على المزيفات العميقة الصوتية. فإنتاجها منخفض التكلفة ويتطلب تسجيلاً لا يتجاوز طوله الثانيتين لصوت الشخص المعني –ويمكن الحصول عليه من منصات التواصل الاجتماعي على سبيل المثال- وذلك لتوليد مقطع صوتي مُقنِع إلى درجة مخيفة. وقد شهدت الولايات المتحدة عدداً من الحالات الشهيرة التي تلقى فيها الضحايا مكالمات استغاثة من أحبائهم يقولون فيها إنهم تعرضوا للخطف ويطلبون دفع الفدية لقاء تحريرهم، ليتبين لاحقاً أن المتصلين لم يكونوا سوى محتالين يستخدمون تسجيلات صوتية عميقة التزييف.

يقول شانكالييني: "على الناس أن يدركوا أن هذه الأساليب باتت ممكنة اليوم، ويجب أن يدركوا أن حيلة الأمير النيجيري لم تعد قابلة للكشف من خلال اللغة الإنجليزية الركيكة بعد الآن". ويضيف قائلاً: "أصبح بإمكان الناس أن يتصلوا بك هاتفياً باستخدام صوت آخر، ويمكنهم أن يضعوك في موقف مثير للقلق بشدة". ويقول إنه ثمة بعض الأساليب التي يمكن للأفراد اتباعها لحماية أنفسهم. ينصح شانكالييني بأن يتفق الأشخاص الذين تجمعهم صلة وثيقة على كلمة سرية يتداولونها فيما بينهم وتخضع للتغيير بانتظام، لمساعدتهم على تأكيد هوية الشخص الذي يتصل بهم. ويقول: "لقد اتفقت مع جدتي على استخدام كلمة سرية خلال مكالماتنا".

تجاوز عمليات التحقق من الهوية

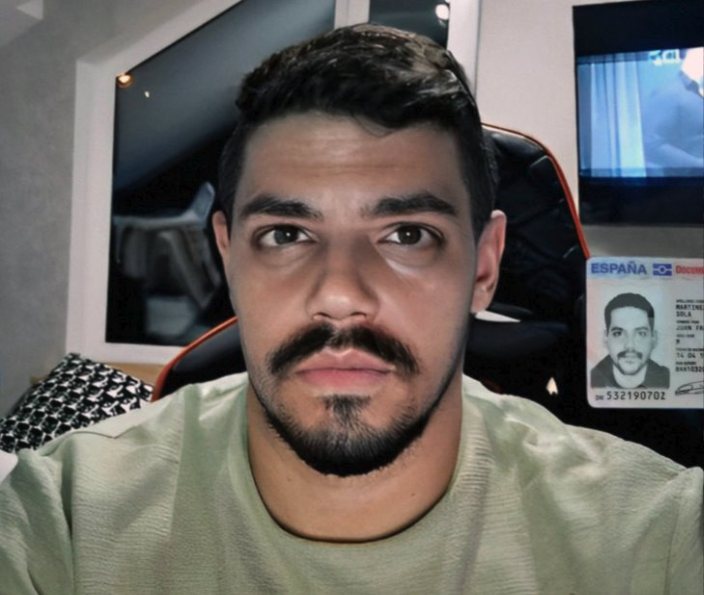

ثمة أسلوب آخر يستخدم فيه المجرمون المزيفات العميقة، وهو تجاوز أنظمة التحقق من الهوية التي تستخدم عملية "تحديد هوية العميل" (know your customer). تستخدم المصارف وبورصات العملات المشفرة هذه الأنظمة للتأكد من أن عملاءها أشخاص حقيقيون. وتفرض على المستخدمين الجدد التقاط صورة لأنفسهم وهم يحملون وثيقة تعريف فيزيائية أمام الكاميرا. لكن المجرمين بدؤوا يبيعون على منصات مثل تيليجرام تطبيقات تتيح الالتفاف على هذا الشرط.

اقرأ أيضاً: 6 طرق غير متوقعة لاستخدام العملات المشفرة

ينفذ هؤلاء المجرمون هذه العملية من خلال تقديم بطاقة هوية مزيفة أو مسروقة، ووضع صورة عميقة التزييف فوق وجه شخص حقيقي لخداع نظام التحقق من الهوية على كاميرا هاتف يعمل بنظام أندرويد (Android). وقد وجد شانكالييني أمثلة لأشخاص يقدمون هذه الخدمات لموقع العملات المشفرة باينانس (Binance) مقابل مبلغ زهيد لا يتجاوز 70 دولاراً. ويقول: "ما زالت هذه الخدمات بسيطة للغاية". تشبه التقنيات التي يستخدمها هؤلاء الفلاتر الموجودة في منصة إنستغرام (Instagram)، حيث يمكن وضع وجه شخص آخر بدلاً من وجهك.

ويقول: "ما يمكننا توقعه في المستقبل هو استخدام المجرمين مزيفات عميقة فعلية، كي تتمكن من إجراء مصادقة أكثر تعقيداً".

تقديم خدمة كسر الحماية

إذا سألت معظم أنظمة الذكاء الاصطناعي عن طريقة صنع قنبلة، فلن تحصل على إجابة مفيدة.

ويُعزى هذا إلى الإجراءات الوقائية المتعددة التي اتخذتها شركات الذكاء الاصطناعي كي تمنع نماذجها من نشر معلومات مؤذية أو خطيرة. ولهذا، قرر المجرمون السيبرانيون أن يتخلوا عن فكرة بناء نماذج ذكاء اصطناعي تخصهم من دون اتخاذ إجراءات وقائية كهذه، فهي عملية مكلفة وصعبة وتستغرق الكثير من الوقت، وبدؤوا بدلاً من ذلك يعتمدون توجهاً جديداً: تقديم خدمة كسر الحماية.

اقرأ أيضاً: دليلك لتدريب نماذج الذكاء الاصطناعي دون انتهاك حقوق الملكية الفكرية والنشر

تتضمن معظم النماذج قواعد تحدد كيفية استخدامها. وتتيح عملية كسر الحماية للمستخدمين التلاعب بنظام الذكاء الاصطناعي من أجل دفعه إلى توليد نتائج تنتهك هذه السياسات، مثل كتابة رموز برمجية لبرنامج فدية خبيث، أو توليد نص يمكن استخدامه في رسائل إلكترونية احتيالية. تقدم بعض الخدمات مثل إسكيب جي بي تي (EscapeGPT) وبلاك هات جي بي تي (BlackhatGPT) إمكانية الوصول المجهول الهوية إلى واجهات برمجة التطبيقات للنماذج اللغوية والأوامر النصية المخصصة لكسر الحماية، التي يجري تحديثها بانتظام.

ولمكافحة هذه الصناعة السرية المتنامية، يتعين على شركات الذكاء الاصطناعي، مثل أوبن أيه آي (OpenAI) وجوجل إجراء عمليات صيانة في كثير من الأحيان لسد الثغرات الأمنية التي قد تتيح إمكانية إساءة استخدام هذه النماذج. تعتمد خدمات كسر الحماية على حيل مختلفة من أجل اختراق آليات الأمان، مثل توجيه أسئلة افتراضية أو توجيه الأسئلة بلغة أجنبية. ثمة لعبة مطاردة مستمرة تدور بين شركات الذكاء الاصطناعي التي تحاول منع نماذجها من أن تسيء التصرف من جهة، والجهات الفاعلة الخبيثة التي تتوصل باستمرار إلى أوامر نصية أكثر ابتكاراً لكسر الحماية من جهة أخرى.

يقول شانكالييني إن هذه الخدمات تصب في مصلحة المجرمين. ويضيف: "إن مواكبة عمليات كسر الحماية عملية مضنية. فبعد التوصل إلى أسلوب جديد، يجب اختباره، ثم يجري استخدامه بضعة أسابيع، ثم تحدث أوبن أيه آي نموذجها. يمثل كسر الحماية خدمة مثيرة للاهتمام للغاية بالنسبة إلى المجرمين".

جمع المعلومات الشخصية عبر الإنترنت ونشرها والمراقبة

يقول بالونوفيتش إن نماذج الذكاء الاصطناعي اللغوية ليست أداة مثالية للتصيد الاحتيالي (phishing) فحسب، بل أيضاً للكشف عن المعلومات الخاصة والكافية لتحديد هوية شخص معين عبر الإنترنت (doxxing). يُعزى هذا إلى أن نماذج الذكاء الاصطناعي اللغوية مُدَربة على كميات ضخمة من بيانات الإنترنت، بما فيها البيانات الشخصية، وتستطيع أن تستنتج الموقع الجغرافي لشخص ما، على سبيل المثال. وكمثال على سير هذه الآلية، يمكنك أن تطلب من بوت دردشة أن يتظاهر بأنه محقق خاص لديه خبرة في جمع المعلومات عن الأشخاص. بعد ذلك، يمكنك أن تطلب منه أن يحلل النص الذي كتبته الضحية المفترضة، ويستنتج المعلومات الشخصية من الأدلة غير المباشرة الواردة في النص، مثل تحديد العمر بناء على التاريخ الذي بدأت فيه مرحلة الدراسة الثانوية، أو تحديد مكان السكن بناء على المعالم المميزة التي يذكرها خلال تنقلاته اليومية. كلما زادت المعلومات المتوفرة عن الضحية عبر الإنترنت، أصبح كشف هويتها أسهل.

كان بالونوفيتش جزءاً من فريق الباحثين الذي اكتشف أواخر العام الماضي أن النماذج اللغوية الكبيرة، مثل جي بي تي 4 (GPT-4) ولاما 2 (Llama 2) وكلود (Claude)، قادرة على استنتاج المعلومات الحساسة المتعلقة بالأفراد، مثل الانتماء العرقي والموقع الجغرافي والمهنة، وذلك بالاعتماد فقط على محادثات رتيبة وعادية أجروها مع بوت دردشة. من الناحية النظرية، يمكن لأي شخص قادر على الوصول إلى هذه النماذج أن يستخدمها بهذه الطريقة. منذ نشر ورقتهم البحثية، ظهرت خدمات جديدة تستغل هذه الميزة في النماذج اللغوية. وعلى حين أن وجود هذه الخدمات لا يشير بصورة مباشرة إلى وجود نشاط إجرامي، فإنه يبرز القدرات الجديدة التي يمكن للجهات الفاعلة الخبيثة أن تستغلها. وإذا تمكن الأفراد العاديون من بناء أدوات مراقبة على هذه الشاكلة، فمن المحتمل أن يكون لدى الجهات الفاعلة المرتبطة بالحكومات أنظمة أفضل بكثير، على حد تعبير بالونوفيتش. ويقول: "الطريقة الوحيدة أمامنا لمنع حدوث هذه الأشياء هي العمل على تعزيز التدابير الدفاعية". ويضيف قائلاً إن على الشركات الاستثمار في حماية البيانات وأمنها. أما بالنسبة إلى الأفراد، فإن تعزيز الوعي أمر جوهري. يقول بالونوفيتش إنه يجب على الناس أن يفكروا ملياً فيما يشاركونه عبر الإنترنت، ويقرروا إن كانوا يشعرون بالارتياح إزاء استخدام معلوماتهم الشخصية المفصلة في النماذج اللغوية.