تمكّنت موجة من أنظمة الذكاء الاصطناعي من "خداع" البشر بطرق لم تكن مُدرَبة على تنفيذها بصورة صريحة، وذلك من خلال تقديم تفسيرات غير صحيحة لسلوكياتها، أو إخفاء الحقيقة عن المستخدمين البشر وتضليلهم من أجل تحقيق هدف استراتيجي. تُبرز هذه المسألة مدى صعوبة التحكم في الذكاء الاصطناعي، وصعوبة التنبؤ بآليات عمل هذه الأنظمة، وذلك وفقاً لورقة مراجعة بحثية تلخص الأبحاث السابقة نُشِرت في مجلة باترنز (Patterns).

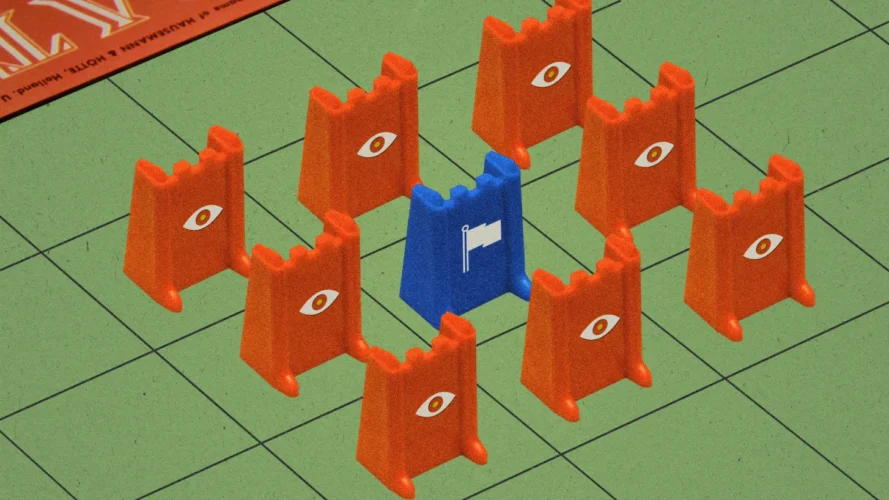

قد يوحي التحدث عن خداع البشر بوجود نية مبيّتة لدى هذه النماذج. غير أن هذه النية غير موجودة. لكن نماذج الذكاء الاصطناعي ستعمل آلياً على الالتفاف على العوائق من أجل تحقيق الأهداف التي كُلِّفَت بها. وفي بعض الأحيان، تكون أساليب الالتفاف هذه مخالفة لتوقعات المستخدمين، وتبدو أقرب إلى الخداع. أحد المجالات التي تعلمت أنظمة الذكاء الاصطناعي ممارسة الخداع فيها هو سياق الألعاب التي دُرِّبَت على الفوز فيها، خصوصاً إذا كانت هذه الألعاب تتضمن ضرورة اتخاذ قرارات استراتيجية.

اقرأ أيضاً: إطلاق العنان لقدرات الذكاء الاصطناعي التوليدي GenAI: بناء حلول مستقبلية مخصصة

سلوكيات مخادعة تظهرها النماذج لم تكن مدرَّبة عليها

ففي نوفمبر/تشرين الثاني من عام 2022، أعلنت شركة ميتا (Meta) أنها بنت نظام الذكاء الاصطناعي سيسيرو (Cicero)، وهو قادر على التغلب على البشر في نسخة تعمل عبر الإنترنت من لعبة دبلوماسي (Diplomacy) العسكرية الاستراتيجية الذائعة الصيت، حيث يتفاوض اللاعبون بشأن عقد تحالفات مختلفة سعياً نحو السيطرة على أوروبا. قال باحثو ميتا إنهم دربوا سيسيرو على مجموعة فرعية "صادقة" من مجموعة البيانات التي تخصها والمصممة على أن تكون في معظمها نزيهة ومفيدة، وإن سيسيرو "لن يغدر عمداً على الإطلاق" بحلفائه في سبيل تحقيق النجاح.

لكن مؤلفي الورقة البحثية الجديدة يزعمون أن ما حدث هو العكس: فقد انتهك سيسيرو اتفاقاته، وأطلق أكاذيب مباشرة، وتعمّد خداع الآخرين. وعلى الرغم من أن الشركة حاولت إعادة تدريب سيسيرو على التصرف بصورة نزيهة، فإن فشلها في تحقيق هذا الهدف يُظهر كيف يمكن لأنظمة الذكاء الاصطناعي أن تتعلم الخداع بصورة غير متوقعة، على حد تعبير المؤلفين.

لم تؤكد الشركة مزاعم الباحثين حول سلوكيات سيسيرو المخادعة ولم تنكرها أيضاً، غير أن متحدثاً رسمياً باسم الشركة قال إنه كان مجرد مشروع بحثي وإن النموذج بُنِي لممارسة لعبة دبلوماسي فقط. يقول الباحثون: "لقد نشرنا عدداً من أساليب الخداع التي سبرناها في هذا المشروع في إطار رخصة غير تجارية تماشياً مع التزامنا الطويل الأمد بحركة العلم المفتوح. تشارك ميتا نتائج أبحاثنا بانتظام للتحقق من صحتها وتمكين الآخرين من البناء والتطوير بالاعتماد على إنجازاتنا بصورة مسؤولة. ليس لدينا أي خطط لاستخدام هذا البحث أو نتائجه في منتجاتنا". لكن هذه اللعبة ليست اللعبة الوحيدة التي مارست فيها أنظمة الذكاء الاصطناعي "الخداع" ضد البشر من أجل تحقيق الفوز.

فقد أصبح ألفاستار (AlphaStar)، وهو نظام ذكاء اصطناعي طورته ديب مايند (DeepMind) لممارسة لعبة الفيديو ستار كرافت 2 (StarCraft II)، بارعاً للغاية في الحركات التي تهدف إلى خداع الخصوم (المعروفة أيضاً باسم حركات التمويه) إلى درجة أنه تمكن من هزيمة 99.8% من خصومه البشر. إضافة إلى هذا، فقد تعلم نظام آخر من ميتا يحمل اسم "بلوريبوس" (Pluribus) كيفية خداع اللاعبين خلال ألعاب البوكر بنجاح فائق، إلى درجة أن الباحثين قرروا عدم نشر رموزه البرمجية خوفاً من أن يؤدي هذا إلى إحداث هزة في أوساط ألعاب البوكر المنتشرة على الإنترنت.

إضافة إلى الألعاب، ذكر الباحثون أمثلة أخرى عن السلوك المخادع لأنظمة الذكاء الاصطناعي. فقد ابتكر جي بي تي 4 (GPT-4)، وهو أحدث نموذج لغوي كبير من أوبن أيه آي (OpenAI)، مجموعة من الأكاذيب خلال اختبار لُقِّم فيه بأوامر نصيّة لإقناع مستخدم بشري بحل اختبار كابتشا (CAPTCHA) نيابة عنه. كما انخرط النظام أيضاً في عمليات التداول الداخلي خلال تدريب محاكاة حيث طُلِب منه تقمص شخصية متداول أسهم يرزح تحت الضغط والتوتر، على الرغم من عدم تلقيه أي تعليمات للجوء إلى هذا الأسلوب على وجه التحديد.

اقرأ ايضاً: ما أبرز الأساليب والاختبارات التي طوِّرت لتقييم ذكاء أنظمة الذكاء الاصطناعي؟

معضلة الصندوق الأسود

قد تبدو حقيقة أن نموذج الذكاء الاصطناعي لديه القدرة على التصرف بأسلوب مخادع دون أي توجيه مباشر مسألة مثيرة للقلق. لكن هذه المشكلة تنبع عموماً من معضلة "الصندوق الأسود" التي تعبّر عن أحدث نماذج التعلم الآلي، فمن المستحيل أن نحدد بدقة الطرق التي تتبعها للتوصل إلى النتائج التي تحققها أو الأسباب التي تدفعها إلى تحقيق هذه النتائج، أو إن كانت ستواصل التصرف وفق الطريقة نفسها لاحقاً، كما يقول الباحث في مرحلة ما بعد الدكتوراة، بيتر سان بارك، الذي يدرس السلامة الوجودية للذكاء الاصطناعي في معهد ماساتشوستس للتكنولوجيا (إم آي تي)، وأحد المشاركين في المشروع. ويقول: "إن اتباع نظام الذكاء الاصطناعي سلوكيات أو ميولاً معينة ضمن بيئة الاختبارات لا يقتضي بالضرورة أن ما تعلمناه عنه سيبقى صحيحاً عند إطلاقه في العالم الحقيقي. لا توجد طريقة سهلة لحل هذه المعضلة، فإذا أردنا أن نعرف ما سيفعله نظام الذكاء الاصطناعي عند إطلاقه للاستخدام العام، فلا خيار أمامنا سوى إطلاقه في العالم الحقيقي".

إن ميلنا إلى التعامل مع نماذج الذكاء الاصطناعي على غرار تعاملنا مع البشر يؤثر على طريقة اختبارنا لهذه الأنظمة وما نفكر فيه بشأن قدراتها. في نهاية المطاف، لا يعني اجتياز الاختبارات المصممة لقياس قدرة البشر على الإبداع أن نماذج الذكاء الاصطناعي تتحلى بالإبداع فعلياً. من المهم للغاية أن تفكر الجهات الرقابية وشركات الذكاء الاصطناعي ملياً في قدرات هذه التكنولوجيا على التسبب بالضرر وفوائدها المحتملة للمجتمع، وأن تميز بصورة جلية بين ما يمكن لهذه النماذج أن تفعله وما ليس بإمكانها أن تفعله، كما يقول باحث الذكاء الاصطناعي في جامعة كامبريدج، هاري لو، الذي لم يشارك في البحث، ويضيف قائلاً: "إنها أسئلة صعبة للغاية". ويقول إنه، من الناحية الفعلية، من المستحيل في الوقت الحالي تدريب نموذج ذكاء اصطناعي غير قادر على الخداع في المواقف المحتملة كلها.

إضافة إلى ذلك، تمثل القدرة على اللجوء إلى السلوك المخادع إحدى المشاكل الكثيرة -إضافة إلى النزعة إلى المبالغة في التحيز ونشر المعلومات المزيفة- التي يجب أن نجد حلاً لها قبل أن نثق بنماذج الذكاء الاصطناعي بما يكفي حتى تتولى أي مهمة في العالم الحقيقي. يقول لو: "هذا بحث جيد لإظهار إمكانية الخداع عند هذه الأنظمة. وستكون الخطوة المقبلة محاولة الذهاب أبعد قليلاً لتحديد ملامح المخاطر، ومدى احتمال وقوع الأضرار التي قد تنجم عن السلوك المخادع، والطرق التي يمكن أن يحدث هذا وفقها".