ستساعد قاعدة بيانات مكونة من مقاطع فيديو جديدة وهائلة على تدريب المساعدات الذكية والروبوتات، ولكن هناك مخاوف واضحة حول كيفية استخدام هذه التكنولوجيا.

وتعتمد هذه القدرة على مجموعات بيانات ضخمة مثل إيماج نت (ImageNet)، وهي مجموعة من ملايين الصور الخاضعة لإدارة يدوية، والتي استُخدمت لتدريب معظم أفضل نماذج التعرف على الصور في العقد المنصرم.

لماذا قررت فيسبوك إطلاق إيجو فور دي؟

ولكن الصور الموجودة في مجموعات البيانات هذه تمثل عالماً من الأجسام المُصورة بدقة وعناية، أي إنها عبارة عن معرض صور لا يجسد فوضى الحياة اليومية كما يراها البشر. وبالتالي، فإن جعل الآلات ترى العالم كما نراه يمثل مقاربة جديدة بالكامل. ويرغب مختبر الذكاء الاصطناعي في فيسبوك بأن يحتل موقع الصدارة في هذا التوجه.

ولهذا، قرر إطلاق مشروع إيجو فور دي (Ego4D) لبناء أنظمة ذكاء اصطناعي تستطيع استيعاب المشاهد والنشاطات التي تُرى من وجهة نظر الشخص الأول، أي كما تبدو الأشياء للمشاركين فيها، بدلاً من مراقب خارجي. ويمكن أن نشبه هذا بمجموعة صور غير واضحة ومُلتقطة باستخدام كاميرا جو برو (Go Pro) من قلب المعمعة، بدلاً من مشاهد مُعدّة بعناية ومُصورة من قبل شخص يقف على الخطوط الجانبية. وترغب فيسبوك بأن تصبح إيجو فور دي بالنسبة لفيديوهات الشخص الأول مكافئة لإيماج نت بالنسبة للصور.

فيسبوك ونماذج التعلم العميق

وعلى مدى السنتين الماضيتين، كان قسم أبحاث الذكاء الاصطناعي في فيسبوك فير (FAIR) يعمل مع 13 جامعة حول العالم على تجميع أضخم مجموعة بيانات على الإطلاق لفيديوهات الشخص الأول، بشكل خاص لتدريب نماذج التعلم العميق للتعرف على الصور. وستكون أنظمة الذكاء الاصطناعي المُدربة على مجموعة البيانات هذه أكثر براعة في التحكم بالروبوتات التي تتفاعل مع البشر، أو تفسير الصور التي تلتقطها النظارات الذكية. تقول كريستن جراومان، مديرة المشروع في فير: “لن تتمكن الآلات من مساعدتنا في حياتنا اليومية ما لم تفهم العالم بشكل فعلي من وجهة نظرنا”.

يمكن أن تكون هذه التكنولوجيا مفيدة لمن يحتاجون إلى المساعدة في المنزل، أو إرشاد الناس خلال تعلمهم لأداء مهام محددة. يقول مايكل ريو، وهو باحث في الرؤية الحاسوبية في فريق جوجل براين (Google Brain) وجامعة ستوني بروك في نيويورك، وليس مشاركاً في إيجو فور دي: “إن مقاطع الفيديو في قاعدة البيانات هذه أقرب بكثير إلى ما يراه البشر من حولهم”.

اقرأ أيضاً: لماذا يشكك الباحثون بنماذج التعلم العميق؟

ما هي سلبيات أن ترى الآلات العالم

فهذا البحث مُمول من قبل فيسبوك، وهي شركة عملاقة في مجال التواصل الاجتماعي واتُّهمت في مجلس الشيوخ الأميركي بتفضيل الأرباح على مصالح الناس، وهي تهمة تم تأكيدها في تحقيقات إم آي تي تكنولوجي ريفيو الخاصة.

يقوم نموذج الأعمال لفيسبوك، وغيرها من الشركات التكنولوجية الكبيرة، على استخلاص كل ما يمكن من البيانات حول سلوك الناس على الإنترنت، وبيعه للمعلنين. ويمكن أن يؤدي نظام الذكاء الاصطناعي الموضح في هذا المشروع إلى وصول هذه العملية إلى السلوك اليومي للناس خارج الإنترنت، ويكشف الأغراض الموجودة في منزلك، والنشاطات التي استمتعت بها، والأشخاص الذين أمضيت وقتك معهم، وحتى الأشياء التي حدقت بها لوقت طويل، وهي معلومات على درجة غير مسبوقة من الخصوصية.

تقول جراومان: “يجب أن نعمل على مسألة الخصوصية قبل أن يخرج هذا المشروع من نطاق الأبحاث التجريبية ويتحول إلى منتج، ويمكن أن يكون هذا العمل مستوحى من هذا المشروع”.

اقرأ أيضاً: لماذا تعتمد فيسبوك على راي بان للاستيلاء على وجوهنا؟

إيجو فور دي: مشروع واعد بقاعدة بيانات غير مسبوقة

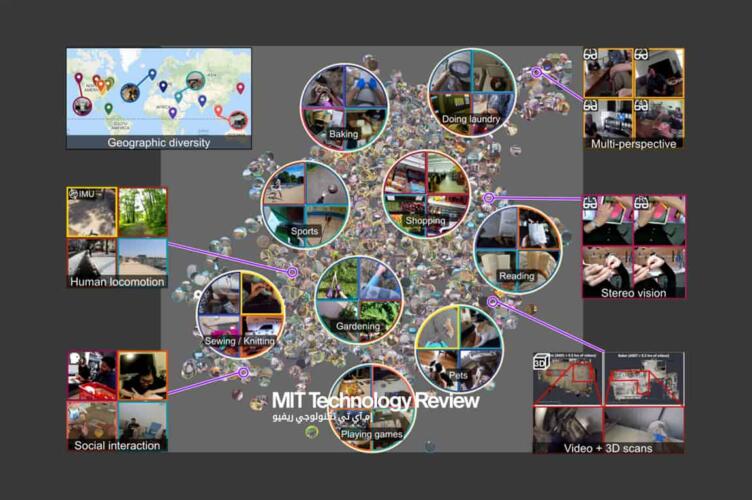

تتألف أكبر مجموعة بيانات سابقة لفيديوهات الشخص الأول من 100 ساعة من التسجيلات لأشخاص في المطبخ. أما مجموعة البيانات إيجو فور دي فتتألف من 3025 ساعة من مقاطع الفيديو التي سجلها 855 شخص في 73 موقع مختلف ضمن 9 بلدان (الولايات المتحدة، المملكة المتحدة، الهند، اليابان، إيطاليا، سنغافورة، المملكة العربية السعودية، كولومبيا، رواندا).

ينتمي المشاركون إلى شرائح عمرية مختلفة وخلفيات مختلفة، فقد طُلب بعضهم للمشاركة بسبب أعمالهم المثيرة للاهتمام بصرياً، مثل الخبازين والميكانيكيين والنجارين ومصممي المساحات الخارجية.

تتألف مجموعات البيانات السابقة عادة من مقاطع فيديو شبه تمثيلية بطول بضع ثوانٍ فحسب. أما في مشروع إيجو فور دي، فقد ارتدى المشاركون كاميرات محمولة على الرأس لفترة تصل إلى 10 ساعات في كل مرة، وصوروا مقاطع فيديو من وجهة نظر الشخص الأول لنشاطات يومية عفوية غير تمثيلية، مثل المشي في الشارع، والقراءة، وغسل الملابس، والتسوق، واللعب مع الحيوانات الأليفة، وممارسة الألعاب اللوحية، والتفاعل مع الآخرين. وتتضمن بعض المقاطع أيضاً أصواتاً مرافقة، وبيانات حول تركيز نظرة المشارك، وعدة لقطات لنفس المشهد. إنها أول مجموعة بيانات بهذا الشكل، كما يقول ريو.

خوارزميات مساعدة في حياتنا

يضاً، أطلق فير مجموعة من التحديات التي يأمل بأنها ستركز جهود الباحثين الآخرين على تطوير هذا النوع من الذكاء الاصطناعي. ويتوقع الفريق أن الخوارزميات المدمجة في النظارات الذكية، مثل نظارات “راي بان” (Ray-Ban) التي أعلنت عنها فيسبوك مؤخراً، ستقوم بتسجيل الحياة اليومية للمستخدمين وتوثيقها. وهذا يعني أن تطبيقات “الكون المتعدد” (Metaverse) للواقع المعزز -أو الافتراضي- يمكن، من الناحية النظرية، أن تجيب عن تساؤلات مثل: “أين مفاتيح سيارتي؟” أو “ماذا أكلت وإلى جانب من جلست خلال رحلتي الأولى بالطائرة إلى فرنسا؟”، يمكن لمساعدات الواقع المعزز أن تفهم ما تحاول فعله، وتقدم تعليمات أو تلميحات مفيدة اجتماعياً.

وعلى الرغم من أن هذه الأشياء قد تبدو أشبه بالخيال العلمي، فإن تحقيقها أصبح أقرب مما نتوقع، كما تقول جراومان. حيث تساعد مجموعات البيانات الضخمة على تسريع الأبحاث. وتضيف جراومان: “لقد أدت إيماج نت إلى تحقيق تطورات كبيرة خلال فترة قصيرة، ويمكن أن نتوقع نفس الشيء من إيجو فور دي، ولكن بالنسبة للعالم من وجهة نظر الشخص الأول بدلاً من صور الإنترنت”.

ما إن جُمعت مقاطع الفيديو، أمضى عاملو التعهيد الجماعي في رواندا فترة إجمالية تصل إلى 25,000 ساعة في مشاهدة الآلاف من مقاطع الفيديو وكتابة الملايين من الجمل التي تصف المشاهد والنشاطات المُصوَّرة. وستُستخدم هذه التعليقات في تدريب أنظمة الذكاء الاصطناعي على فهم ما تشاهده.